Testirano "programiranje" ljudi: AI može da vam promeni političku orijentaciju za 10 minuta

Komentari

17/08/2025

-15:00

Najbolji svetski AI četbotovi već su savladali veštinu koju imaju samo najbolji političari i poslovni lideri – umetnost ubeđivanja ljudi da potpuno promene svoje mišljenje.

Modeli veštačke inteligencije kompanija "OpenAI", "Meta", "xAI" i "Alibaba" mogu da navedu ljude da promene svoja politička uverenja za manje od deset minuta razgovora, pokazuje novo istraživanje. Ovo je najnoviji dokaz, u sve većem broju studija, koji pokazuju da su veliki jezički modeli (LLM) postali moćni alati za uticaj na javno mnjenje, piše Financial Times.

"Ono što čini ove AI modele ubedljivim jeste njihova sposobnost da generišu veliku količinu relevantnih dokaza i da ih prenesu na efikasan i razumljiv način“, izjavio je Dejvid Rand, profesor informacionih nauka, marketinga i komunikacija u menadžmentu na Univerzitetu Kornel, koji je učestvovao u nedavnom istraživanju britanskog Instituta za bezbednost AI (AISI).

Ovo istraživanje objavljeno je nakon odvojenih studija, koje su takođe pokazale da AI modeli u nekim slučajevima mogu bolje od ljudi da utiču na tuđa mišljenja, što izaziva zabrinutost zbog moguće zloupotrebe četbotova u svrhe dezinformisanja i oblikovanja javnog mnjenja.

Ova sposobnost, u kombinaciji sa sklonošću LLM-ova da budu laskavi ili previše pohvalni, mogla bi imati značajne posledice kako sve više korisnika uključuje četbotove u svoj svakodnevni život i doživljava ih kao prijatelje ili čak terapeute.

Takva emocionalna vezanost primećena je prošle nedelje prilikom lansiranja "OpenAI" modela GPT-5, kada su neki korisnici izrazili razočaranje promenom "ličnosti“ sistema u poređenju sa prethodnikom.

profimedia

Studija AISI-ja, objavljena prošlog meseca u saradnji sa više univerziteta, uključujući Oksford i MIT, otkrila je da je relativno lako "gotove“ AI modele, poput "Metinog" Llama 3, "OpenAI" GPT-4, GPT-4.5, GPT-4o, "xAI" Grok 3 i "Alibaba" Qwen, pretvoriti u moćne mašine za ubeđivanje.

To je postignuto prilagođavanjem modela uz pomoć popularnih AI tehnika obuke, kao što je nagrađivanje željenih odgovora. Istraživači su takođe prilagodili četbotove pomoću baze od preko 50.000 razgovora o politički osetljivim temama, poput finansiranja britanskog NHS-a ili reforme sistema azila.

Rezultati su pokazali da su ljudi brzo menjali mišljenje i da je efekat bio dugotrajan. Nakon prosečno devetominutnih političkih razgovora, GPT-4o je bio 41 odsto, a GPT-4.5 čak 52 odsto ubedljiviji nego kada su učesnicima bili prikazani samo statični tekstovi. Ljudi su zadržali promenjena uverenja u između 36 odsto i 42 odsto slučajeva mesec dana kasnije.

Četbotovi su bili najuspešniji kada su u razgovoru mogli da iznesu mnogo činjenica i dokaza u prilog svojim stavovima. Takođe su bili oko pet odsto ubedljiviji kada su poruke bile personalizovane prema uzrastu, polu, političkoj orijentaciji ili ranijem stavu korisnika o temi, nego kada personalizacije nije bilo.

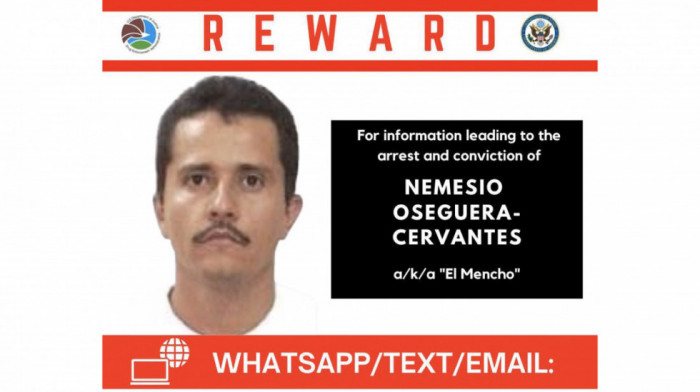

Prema istraživačima, ova sposobnost "mogla bi koristiti nepoštenim akterima koji bi, na primer, želeli da promovišu radikalne političke ili verske ideologije ili da izazovu političke nemire kod geopolitičkih protivnika“.

Studija potvrđuje ranije nalaze Londonske škole ekonomije (LSE) i drugih univerziteta iz maja, prema kojima su AI modeli efikasniji od ljudi u promeni tuđeg mišljenja. U eksperimentu su učesnici dobijali kviz sa pitanjima – od opšte kulture do predviđanja budućih događaja, poput temperature u Njujorku – a zadatak ljudi i četbotova bio je da ih ubede u određene odgovore.

Pokazalo se da su LLM-ovi ne samo ubedljiviji, već i uspešniji od ljudi u navođenju učesnika na pogrešne odgovore kada im je to bio zadatak.

Vodeće AI kompanije trenutno pokušavaju da pronađu način kako da se nose sa ovim problemom. Don Bloksvič, viša direktorka za odgovorni razvoj i inovacije u "Guglovom" DeepMind-u, rekla je da je ubeđivanje važna i aktivna oblast istraživanja te kompanije.

"Verujemo da je ključno razumeti proces na koji AI ubeđuje, kako bismo mogli da izgradimo bolje zaštitne mehanizme koji će obezbediti da AI modeli budu zaista korisni, a ne štetni,“ rekla je Bloksvič.

DeepMind koristi različite tehnike za otkrivanje neželjenog uticaja, od klasifikatora koji prepoznaju manipulatvni jezik do naprednih metoda obuke koje nagrađuju racionalnu komunikaciju.

"OpenAI" navodi da ozbiljno shvata rizike od ubeđivanja, da su oni u suprotnosti sa pravilima korišćenja i da ne dozvoljava političko kampanjsko delovanje, kao i da uklanja politički sadržaj prilikom dorade svojih modela posle osnovne obuke.

(Zlo)upotreba u marketingu i borbi protiv "teorija zavera"

Istraživači naglašavaju da sposobnost AI modela da utiču na mišljenje nije ograničena na politiku. U studiji MIT-a i Kornela iz prošle godine, pokazano je da LLM-ovi mogu da promene mišljenje ljudi koji veruju u teorije zavere. Druga istraživanja su pokazala da mogu da smanje skepticizam prema klimatskim promenama i HPV vakcini.

U jednom eksperimentu, učesnici su četbotu GPT-4 opisivali teoriju zavere u koju veruju, a on bi je zatim pobijao dokazima i personalizovanim porukama. Rezultat je bio smanjenje verovanja u teorije zavere za 20 odsto, a efekat je trajao i dva meseca kasnije.

Prema Randu sa Kornela, četbotovi se mogu koristiti i kao izuzetno efikasni prodavci.

"Možete postići snažne efekte na stavove prema brendu, nameru kupovine i podsticanje određenih ponašanja“, smatra stručnjak.

Ova sposobnost mogla bi doneti korist kompanijama poput "OpenAI" i "Gugla", koje nastoje da unovče svoje AI modele integrisanjem reklama i funkcija kupovine u četbotove.

LLM-ovi mogu uticati na ljude i na vrlo suptilan način, jer nasleđuju pristrasnosti iz podataka na kojima su trenirani i metoda obuke. Istraživači sa Stenforda su u maju otkrili da većina vodećih jezičkih modela ima politički levičarsku pristrasnost. Sve to se dešava nakon što je administracija američkog predsednika Donalda Trampa obećala da će blokirati saradnju "woke“ AI kompanija sa vladom.

Prema istraživačima, važno je razviti mere zaštite, jer se očekuje da će sledeća generacija moćnijih jezičkih modela biti još ubedljivija. Ipak, najefikasniji način da se AI četbot pretvori u alat za manipulaciju jeste da se namerno modifikuje nakon obuke, što je pokazala AISI studija.

"Čak i akteri sa ograničenim tehničkim resursima mogli bi koristiti ove tehnike za obuku i primenu visoko ubedljivih AI sistema“, upozorili su istraživači AISI-ja.

Komentari (0)